[导读]:在robots文件中也限制了的,还是来抓取。全部都是404页面,该怎么办啊? 管他 ### 这蜘蛛假的,别人伪装的 ### 这种不见得是百度蜘蛛,也可能是别人恶意扫描,扫你网站漏洞的...

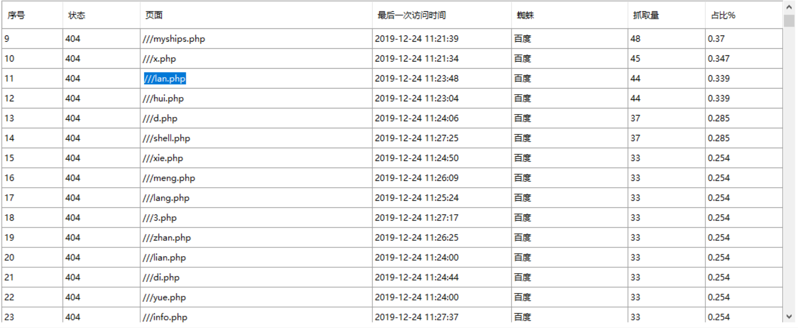

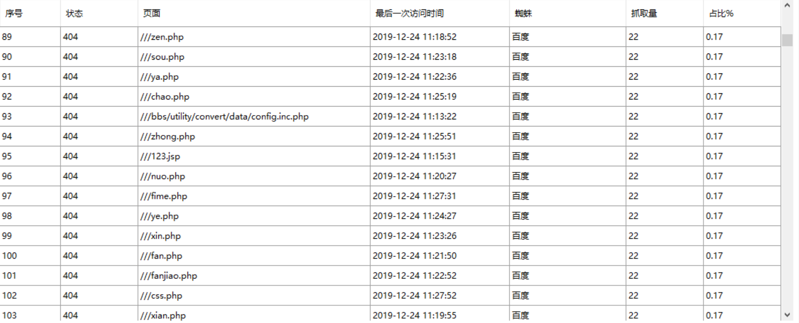

在robots文件中也限制了的,还是来抓取。全部都是404页面,该怎么办啊?

管他

###这蜘蛛假的,别人伪装的

###这种不见得是百度蜘蛛,也可能是别人恶意扫描,扫你网站漏洞的

不用管

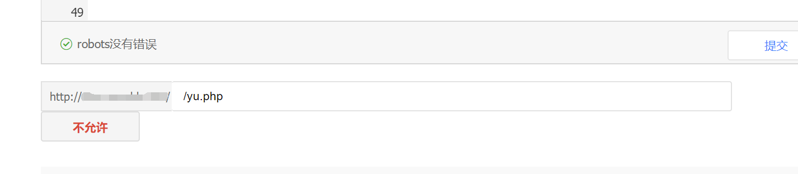

###写一下Robots文件限制一些文件的抓取

###假蜘蛛吧

###我之前也是

一、提交百度站长死链 百度会处理

二、自己删除

三、要想不再被抓取就到Robots里屏蔽

###LIVE意荐

0

robots屏蔽下啊,这样可以提升爬虫效率http://www.syedl.com/

写进Robots文件

###这样不好吧

###别管他

###可以忽略 假蜘蛛可能

写个Robots文件吧

###都是乱来的

恶意扫描,你使用nslookup查询是否百度蜘蛛就知道了

本文来自投稿,不代表微盟圈立场,如若转载,请注明出处:https://www.vm7.com/a/ask/103109.html