[导读]:织梦系统:已经在robots禁止Disallow:/plus/postocar.php,为什么网站日志还出现大量请求该页的404页面。该页是存在的,只是网站没有应用到这个这个页面。 最好修复一下,Robots就像...

织梦系统:已经在robots禁止Disallow:/plus/postocar.php,为什么网站日志还出现大量请求该页的404页面。该页是存在的,只是网站没有应用到这个这个页面。

最好修复一下,Robots就像是一张通告,百度想抓照样会抓

###百度蜘蛛目前对Robots文件的识别率不高,robots对百度基本上没有用的、但是谷歌是完全支持的

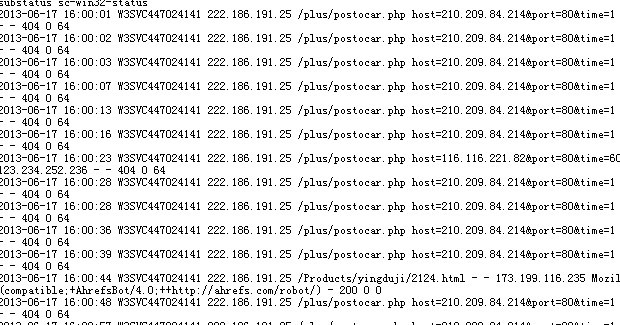

###网站日志是记录web服务器接收处理请求以及运行时错误等各种原始信息的文件,也就是服务器日志。

Robots.txt是一个协议,而不是一个命令。robots.txt是搜索引擎在访问网站的时候要查看的第一个文件,用来告诉蜘蛛程序在服务器上什么文件是可以被查看的。

你在robots里屏蔽了/plus/这个文件,只是蜘蛛不抓取、不请求你这个文件。

访问日志中出现大量该页面的404页面是因为除蜘蛛以外的人或者程序访问了该页面。

404错误分两种:一种是硬404,另一种软404。一般的就是硬404错误,很多大型门户网站为什么被降权就是软404。我们在发现404错误时,要分析为什么导致的404错误,应该如何去修复404错误。如果不能修复404错误,我们把404错误的地址向百度提交。如果控制不了404错误时才用Robots禁止,如果404错误太多了,就提出网站改版。

###把这些404页面都提交给百度,大概过1-2周左右就会没啦。

###蜘蛛不抓,但可能有人点的啊 亲

本文来自投稿,不代表微盟圈立场,如若转载,请注明出处:https://www.vm7.com/a/ask/18737.html