[导读]:个人网站是www点drlmeng点com 8月份的时候站内被降权,首页权重还在 当时判断是因为论坛帖子质量较差导致的,所以屏蔽了百度蜘蛛的抓取,但是被禁止抓取的页面也一直在被蜘...

个人网站是www点drlmeng点com

8月份的时候站内被降权,首页权重还在

当时判断是因为论坛帖子质量较差导致的,所以屏蔽了百度蜘蛛的抓取,但是被禁止抓取的页面也一直在被蜘蛛爬取。

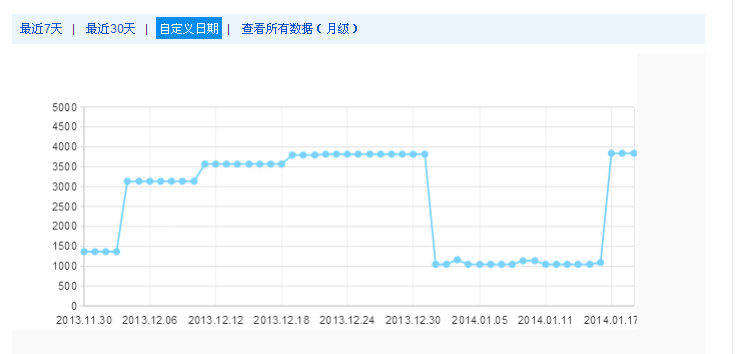

论坛页面当时试过禁止所有的蜘蛛抓取,谷歌很快生效了,但是百度的蜘蛛一直有在抓取,有时候百度搜索找不到论坛的页面,有时候又可以,让我非常抓狂,百度站长工具的索引量在规则设置后数量立刻减少,但又莫名其妙恢复了(看图片的最近几天的索引量,12月30号后我没再修改过robots文件。)

赞同楼上的书法,Robots写的太乱了。

robots写法需要简单明了,具体的你可以根据,百度站长平台里面的robots生成工具来。

网站降权的原因有很多种,建议从网站自身分析。

disallow:/bbs

disallow:/?s

你可以试试我上面个。

你的Robots写的太乱了,建议将所有bbs的删除,直接用一个disallow:/bbs就解决了

本文来自投稿,不代表微盟圈立场,如若转载,请注明出处:https://www.vm7.com/a/ask/21661.html