蜘蛛爬行死循环如何解决?

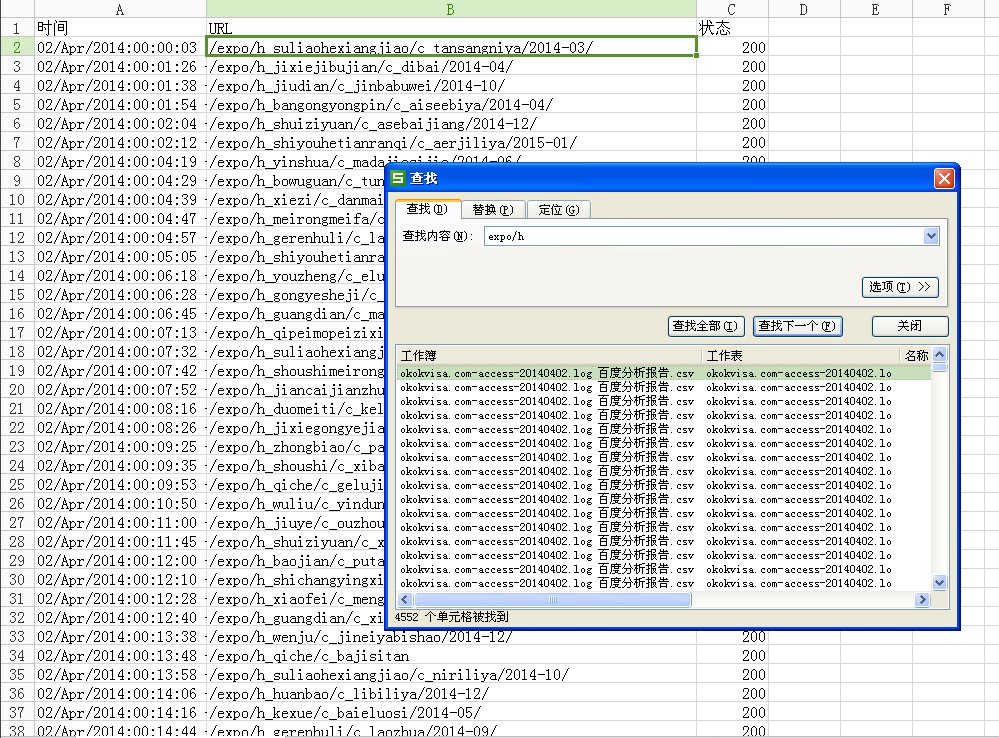

我的网站,蜘蛛一直都在抓取筛选器哪里的链接,5千条爬行记录有4800是在爬那个筛选器的链接,有效内容页几乎不爬。把那个筛选器里面的链接全NF掉貌似也没什么作用。该如何解决呢?

一般通过屏蔽蜘蛛改善收录有几种靠谱的方法:

① Nofollow + Robots.txt

② JS封装

③ 页面缓存(Last-modified + Etag)

④ 调整链接入口(数量 + 位置)

基于你网站的情况,个人认为最适合第四种方法。

至于具体原因,“国际会展”频道内容总数497,各种筛选条件组合后数量轻松上万。也就是说内容总数不多,但筛选条件却不少,以目前的内容数量还不足以支撑这么多的筛选条件,结果是导致绝大多数的筛选结果页都是空的。你可以看下一礼拜内抓取的筛选结果页其中没有内容的能占多大比例,估计不少。。。

所以说你这问题原因不是蜘蛛不抓,而是没得抓。什么nofollow、js之类的自然没用,因为原因没找对嘛。。。

改善抓取的个人建议:

1.调整筛选条件的展现规则,只允许有内容的筛选条件才能展现在前端中

2.增加筛选结果页中内容详情页的调用数量(增加详情页抓取概率,本身数量就不多的,就甭弄啥分页了)

3.充实详情页内容(信息量少、无更新、没给同类相关页面提供链接,所以蜘蛛不会定期重访)

4.筛选结果页TDK修改(上万的筛选页TDK都是一样的。。。。)

谢邀,我的建议是你可以通过筛选器的链接给其他页面更多的导入,方便蜘蛛爬行。

###屏蔽相关的链接可以尝试下。

例如Nofollow 标签添加到你不想蜘蛛爬行的链接。

Robots.txt 也可以添加,禁止相关的抓取。

筛选器的你可以在空页面随机调列表

###楼上正解,筛选器用ajax实现吧,否则就算不死循环爬寻也会制造出若干相似页面。

###筛选器 最好用JS 你看看那些大站怎么做的

###如果筛选器没有什么实质性的内容,那就屏蔽蜘蛛吧(Robots.txt )

NF只是不传递权重,蜘蛛会照样爬行链接。

本文来自投稿,不代表微盟圈立场,如若转载,请注明出处:https://www.vm7.com/a/ask/23975.html