[导读]:刚开始建站时在robots.txt里禁止了所有的蜘蛛,前两天刚做好就改为了允许所有蜘蛛抓取。 但是今天分析日志时发现了几十个404的错误,原因都是蜘蛛抓取了一个叫/Article/文件里...

刚开始建站时在robots.txt里禁止了所有的蜘蛛,前两天刚做好就改为了允许所有蜘蛛抓取。

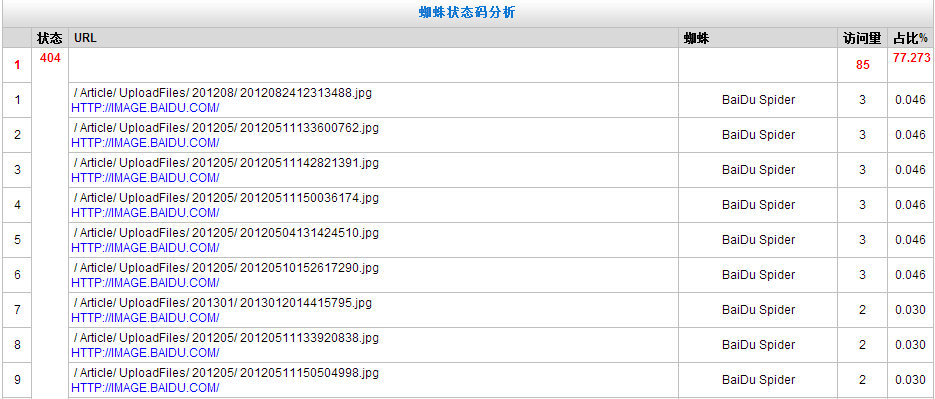

但是今天分析日志时发现了几十个404的错误,原因都是蜘蛛抓取了一个叫/Article/文件里的图片。

但是我的网站根本就没有这个文件,我自己也没有找到,请问各位师兄这是怎么回事?

现在我已经在robots.txt里面禁止了这个文件的访问,这样可以吗?

这个应该是光年SEO日志分析工具吧!

这个查404不准确。最好用editplus打开log后缀的日志文件。用ctrl+F查找404页面。

对于返回404状态码的设置屏蔽,禁止抓取,同时在百度站长平台工具提交死链文件,对蜘蛛爬行和抓取有帮助的。

百度蜘蛛能够爬行这个文件夹,说明这个文件目录URL在网站存在链接的。

本文来自投稿,不代表微盟圈立场,如若转载,请注明出处:https://www.vm7.com/a/ask/29377.html