[导读]: 这个去掉就可以了 ### 找到 Robots文件 删除禁止代码 你把搜索引擎禁止抓取了 ### 你去fTP里面看看这个 ribots的文件~把里面的指令给删掉就可以了 ### 你怕不是把全站多禁止蜘蛛...

这个去掉就可以了

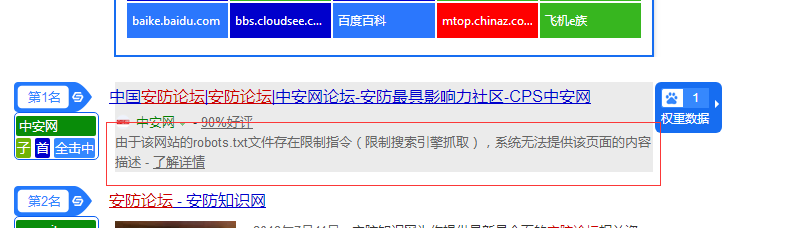

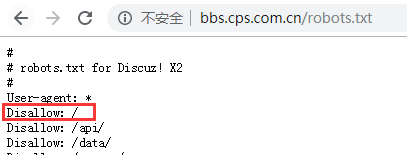

###找到Robots文件 删除禁止代码 你把搜索引擎禁止抓取了

###你去fTP里面看看这个 ribots的文件~把里面的指令给删掉就可以了

###你怕不是把全站多禁止蜘蛛爬取了把

###修改robot就好了

###你的 ribots设置出现问题了啊,改了就行了

###一楼正解

###一楼回答正确disallow:/ 删掉即可

###去掉文件中的指令就好了

###找到Robots文件,删除禁止抓取指令

###这样子不是一个都没收录

###网站robost文件禁止搜索引擎抓取了,去ftp下载下来改一下就可以了

###你的Robots.txt disallow所有了,所以不能抓取,可以照抄我这个

###一楼回答完成正确。

###网站根目录修改Robots.txt的抓取权限,把你希望被抓取的页面设置为允许抓爬 允许抓爬示例:User-agent: Baiduspider

allow:/

###顶下,虽然看不懂

本文来自投稿,不代表微盟圈立场,如若转载,请注明出处:https://www.vm7.com/a/ask/66553.html