[导读]:我半年前在robots中就写入了Disallow: /a 但是今天我看2019年7月24日 日志中,依旧有很多/a下的地址被爬了,而且还返回404,这是怎么回事? 如图: 百度是遵守这个协议的,但是蜘...

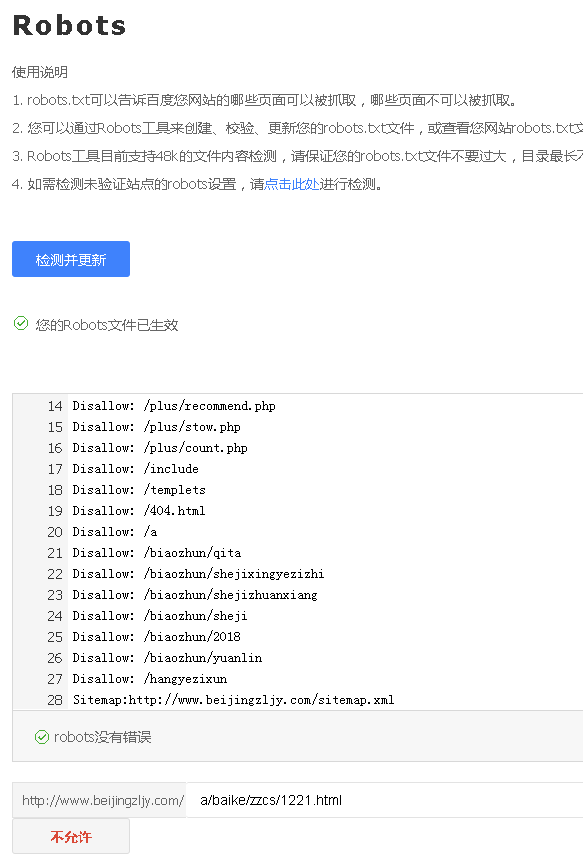

我半年前在robots中就写入了Disallow: /a

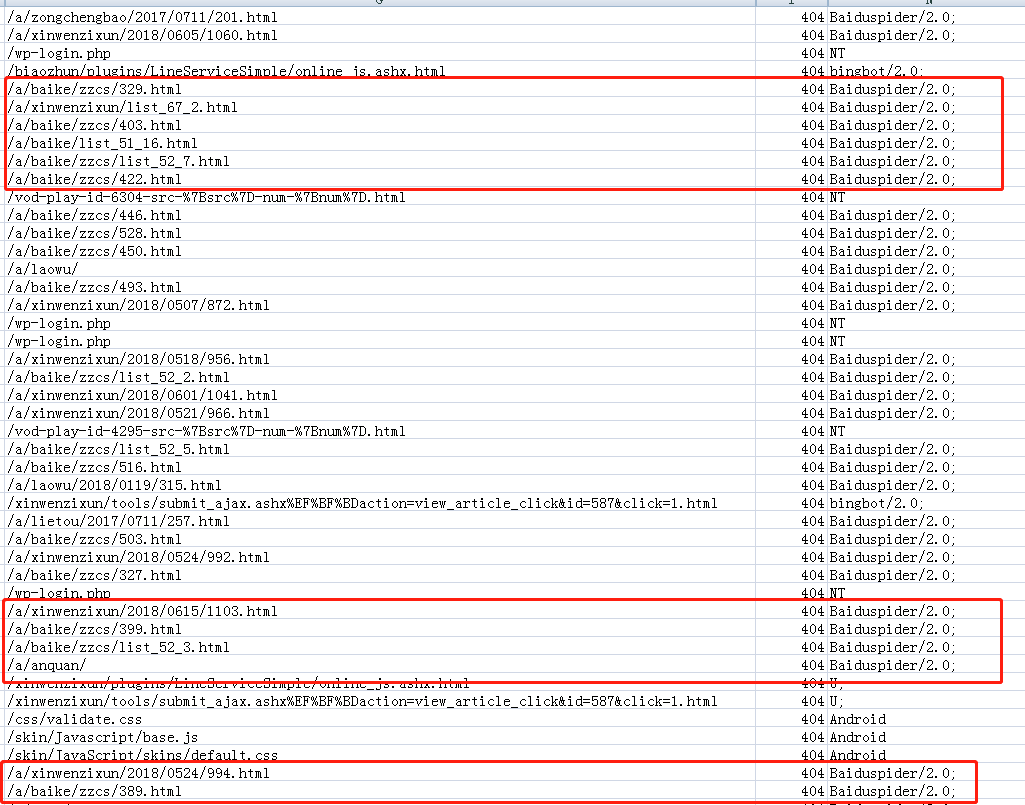

但是今天我看2019年7月24日 日志中,依旧有很多/a下的地址被爬了,而且还返回404,这是怎么回事?

如图:

百度是遵守这个协议的,但是蜘蛛只是在抓你网站的时候遇到网址不顺着往下抓,在站外遇到这个链接还是会爬的

###不是你的问题,这个协议是君子协议,你可以高速各大搜索引擎不要去抓取,但是它如果非要爬行抓取谁也没办法的

###检查下是你写错了还是蜘蛛不遵守规则了

###我的有时候也出现这个问题

本文来自投稿,不代表微盟圈立场,如若转载,请注明出处:https://www.vm7.com/a/ask/75075.html