[导读]:看到很多网站都没有 robots 文件,那么一个常规的robots.txt文件应该要这么写呢,小编今天给大家来说说robots.txt怎么写,robots文件常规的写法。 上图是小编的robots文件,我的个人博客是织...

看到很多网站都没有robots文件,那么一个常规的robots.txt文件应该要这么写呢,小编今天给大家来说说robots.txt怎么写,robots文件常规的写法。

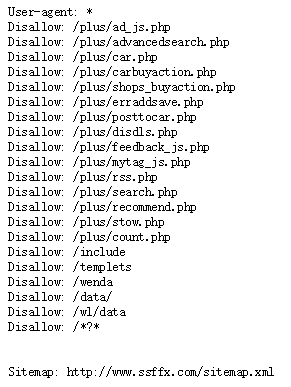

上图是小编的robots文件,我的个人博客是织梦的系统,织梦默认是有部分robots文件的,小编先给大家解释一下其中的写法。

1、允许所有搜索引擎访问 User-agent: * Allow:

2、禁止所有搜索引擎访问 User-agent: * Disallow: /

3、网站地图:Sitemap:

哪些页面要用robots.txt屏蔽

知道怎么写了,但很多朋友还是不知道哪些页面需要屏蔽,让搜索引擎不被访问,其实很简单,不想被搜索引擎抓取的页面就屏蔽,那么哪些页面是我们不想被搜索引擎抓取的呢。

空白页面:什么是空白页面,比如注册页面、联系我们、关于我们等页面属于空白页面,因为这种页面在搜索引擎看来是没有意义的,没有人会搜索注册来到你的网站。

后台页面:后台是不被搜索引擎收录的,所以我们需要robots屏蔽后台登陆页面。

动态页面:通常情况下,我们网站都会做伪静态,那么动态页面我们会屏蔽掉。

总结:robots文件有必要写,一来给搜索引擎做个更好的第一印象,其次是给搜索引擎做一个网站地图。

99%的人还阅读了:

robots是什么,robots怎么写?

屏蔽百度蜘蛛的方法

本文来自投稿,不代表微盟圈立场,如若转载,请注明出处:https://www.vm7.com/a/ziyuan/1439.html